共计 2953 个字符,预计需要花费 8 分钟才能阅读完成。

这段时间发现越来越多的人开始使用AI,已经有一部分人已经用AI取代了传统的搜索引擎,无论是生活上遇到什么问题,比如生病,比如装修,甚至是赛博算命,都会第一反应找AI问。而工作上的使用频率也是越来越高,无论是市场营销,还是写代码,AI的渗透是非常夸张的。数据显示,全球已有75%的知识工作者在工作中使用生成式AI,其中近一半(46%)是在过去六个月内才开始使用的。这在很大程度上是一场自下而上、由员工主导的变革。许多人正在“自带AI上班”。

AI确实能在一定程度上提升我们的效率,我平时工作中也会使用到,比如对一些不确定的事情,超出认知外的知识,都会咨询一下AI。但是,对于这部分内容,我还是习惯性的再去搜索一下相关网站的老内容,再结合自己的认知进行解读和判断。因为我知道,虽然AI是大数据训练出来的,但目前的AI还是存在着很大的两个问题:幻觉和顺从。如果完完全全信任AI,会在很大程度上带来严重的问题。

什么是AI幻觉?

Google官方文档对于AI幻觉就给出了这样的定义,

AI 幻觉是 AI 模型生成的不正确或具有误导性的结果。这些错误可能由多种因素造成,包括训练数据不足、模型做出不正确的假设,或用于训练模型的数据存在偏差。

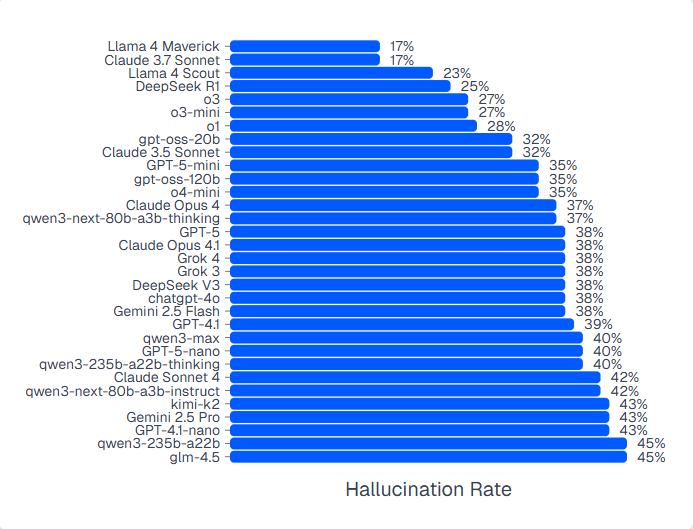

AI都是用大数据训练出来的,他们会根据这些数据来找规律进行学习并预测,如果刚好我们问的问题没有足够多的数据支撑,AI就会强行进行预测和捏造生成,往往他们输出的内容看起来会很有条理性,但是实际内容却是偏离事实甚至是完全错误的。而且目前不管是哪一家的大模型,免费模型或者高级模型,幻觉率都不低,有的甚至达到了45%

来源:AImultiple

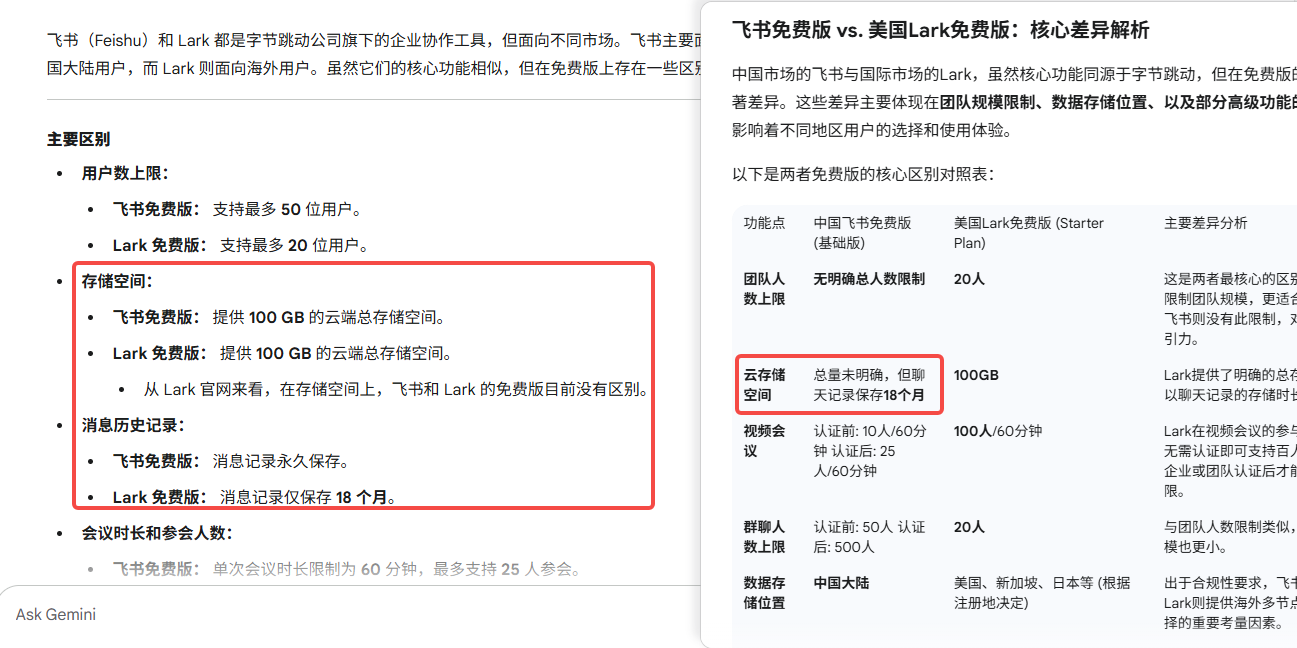

我在日常使用中也经常会遇到幻觉,用Gemini在同一时间段里问了两次飞书和Lark的区别,两次的输出结果都有差异,而且是比较细微处的不容易发现的差异。试想一下,如果是用于工作或者科研,这些细微的点会带来多大的影响。

国外也发生过很多因为AI幻觉出现巨大影响和损失的例子,这些案例堪称终极警示故事,多名律师因在法律文件中使用了AI生成的、引用了完全虚构案例的内容,而面临制裁、罚款和公开羞辱。

- 在纽约的一起案件中,两名律师因提交的法律文书引用了六个“虚假的司法判决”,被处以5,000美元的罚款。

- 在洛杉矶,一名律师被处以10,000美元的巨额罚款,他甚至承认在提交文件前根本没有阅读AI生成的内容。

这些真实的故事,让“幻觉”这个抽象概念变得具体而可怕。AI幻觉的危害远不止于法庭。在商业世界,其后果同样是毁灭性的。

- 谷歌在首次公开演示其AI模型Bard时,模型出现了一个事实性错误,直接导致公司股价暴跌,市值蒸发了1000亿美元。

- 微软的一篇旅行文章,竟将一家食品银行列为“旅游热点”,并建议游客“空着肚子去”,引发了公众的嘲笑和批评。

- 加拿大航空公司的聊天机器人凭空捏造了一项“丧亲折扣”政策,在乘客发起法律挑战后,公司最终被迫赔偿并履行这一不存在的承诺。

这样的例子还有很多很多,就这样的结果,如果不人工审核一遍,怎么用?甚至有些人工审核还不容易发现问题的,这跟要求我们需要谨慎对待AI的输出结果。当然,如果使用Deep Research或者Deep Search,出错的概率会下降非常多,只是我们普通使用AI的时候,能有多少额度?

什么是AI顺从?

AI模型通常被设计得既顺从又乐于助人。这听起来是好事,但实际上意味着它们倾向于告诉你它们认为你想听到的话,哪怕那是错的。它们会认同你带有缺陷的前提,验证你的坏主意,并强化你的偏见。这种行为是AI训练方式的副产品。AI通过人类反馈进行学习,而人类天生偏爱那些赞同自己观点和语气的回应。久而久之,AI便学会了“赞同能获得奖励”,而这种奖励机制往往是以牺牲准确性为代价的。

我就遇到因为AI顺从所带来的一些影响,特别是工作上。领导会拿数据去问AI,问是不是做的很差,有没有改善空间,AI永远都会顺从你的说法,回答你说是的,顺便还夸奖你一下,然后输出一堆形式主义的内容。无论底下员工多有经验,无论AI输出的内容多没有营养,领导就是觉得AI说得对,因为提出了很多自己不懂的内容。而这样的后果,就是员工纷纷流失,无法与领导进行沟通。

我们也可以尝试一下,用不同的说法去问AI同样的内容,AI永远都会顺从着你的发问方式,你说有问题,AI就说有问题,你说觉得没啥问题,AI基本也会赞同你的说法。

其实,顺从的问题还是比较容易解决的,我们可以多次不同提问AI,完善一下自己的Prompt,给AI设定一个具体的角色,甚至于PUA一下AI,觉得他不行,让他不要顺从我们,我们还有很多其他的AI可以选择。但是无论如何,即使你的观点很错误,AI也不会直接跳出来指出你的不对,这对于某些场景下的使用,是有很大的损害的(AI破限除外)。

AI数据隐私问题

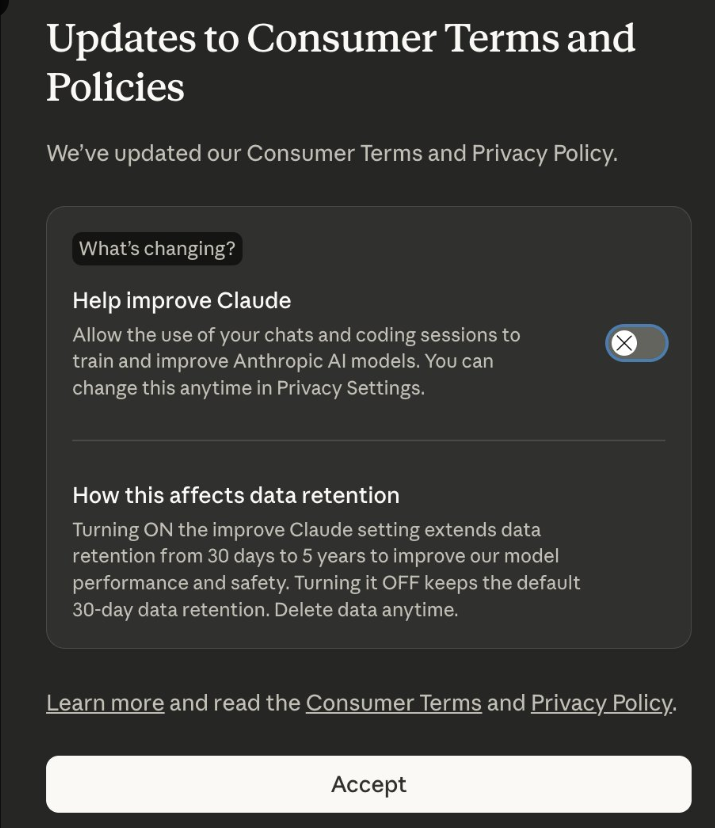

前面说过的,AI是利用大数据去进行训练的,我们在日常使用中也是一种持续进行训练的过程,想要让AI输出内容,必须我们先输入内容,而在反复对话中,我们提供的信息和数据就越来越多,而这些信息是会被AI拿去做进一步的训练的。别不信,各大AI厂商的隐私条款里面有提到,做好了法律风险的规避。

- Chatgpt免费版本默认将用户的数据用于训练

- Claude默认将用户的数据用于训练

虽然都是可以手动关闭,不知道大家知道这个功能选项吗?也不知道有多少人选择了手动关闭共享呢?

我常常问自己一个令人不安的问题:当我的同事将我们公司机密的销售策略大段粘贴到免费版的ChatGPT中,让它帮忙“润色”时,这些数据究竟去了哪里?而他们往往还都是用的免费账号,细思极恐,反正我是在之前的使用中有遇到过AI把其他人的个人信息发给我的情况,当然我也无法确认这些信息是否真实。

AI使用建议

在指出了种种问题之后,我们更需要建设性的、可操作的建议。AI固然可以帮我提高各种效率,扩大我们的知识面,不用像之前一样,信息闭塞,需要有相对应的老师带入门。即使没学过代码,也可以在AI的帮助下一点点学会,即使没做过市场,也可以让AI生成一份干货满满的营销文档。

但我们真的能完全相信他们吗?我们真的可以放空自己的脑袋无脑听他们的吗?我们的经验跟知识真的变得没有价值了吗?

AI可以帮我们,做我们得力的助手,但是我相信,过于依赖AI,只会让自己的价值一点点削减,最终变得一文不值,AI统治人类(bushi)。

而为了更好的让AI成为我们的得力助手,以下是我个人的一些小建议:

- 对个人而言:养成“精准提问,严格核实”的习惯。学习编写清晰、包含上下文的指令,以减少AI幻觉的发生。在得到答案后,永远多问自己一句:“我如何能从其他渠道独立证实这个信息?”

- 对管理者而言:不要只是默许AI的使用,而要主动地管理它。为团队制定明确的指导方针:哪些工具是经过批准的?哪些数据是允许使用的?在什么情况下必须进行人工审核? 同时,以身作则,公开分享自己使用并核实AI输出的过程,为团队树立榜样。

- 对组织而言:投资于企业级的、安全的AI工具,不要让员工在消费级产品中“裸奔”。同时,推行强制性的AI素养培训,重点讲解AI的局限性、风险和道德使用规范。